【摘要】人工智能技术的深度嵌入,正在重塑网络空间的冲突形态与治理逻辑。传统网络空间治理范式,无论是基于命令—控制的强规制,还是侧重市场自律的弱干预,在应对技术的高度自主性、主体的多样弥散性、损害的跨域传导性以及场景的复杂耦合性时,均已显现出系统性不适。对2020年以来全球范围内由人工智能驱动的典型网络空间冲突进行类型学分析,可以识别出四种核心模式:深度伪造与认知操纵、智能化基础设施攻击、算法歧视与社会公正冲突、数据主权与数字霸权博弈。新型冲突的本质已从工具理性驱动转向生成理性驱动,呈现出主体泛在化、手段智能化、影响社会化和责任模糊化等区别于传统冲突的显著特征。有鉴于此,“生成式治理”的创新理论框架应以“风险预防、动态适应、多方协同、智能驱动”为支柱,构建一个能够与人工智能系统共生演进、具备学习和预测能力的动态治理体系,其落地需要制度创新、技术创新和组织创新的协同推进。

【关键词】人工智能 网络空间冲突 生成式治理 数字主权 算法治理

【中图分类号】TP18/D630 【文献标识码】A

【DOI】10.16619/j.cnki.rmltxsqy.2025.13.002

【作者简介】米加宁,北京邮电大学经济与管理学院教授,新质生产力与管理创新研究中心主任。研究方向为生成式治理、新质生产力、数字政府,主要著作有《国家哲学社会科学成果文库·数据科学对社会科学转型的重大影响研究》、《生成式人工智能十大认识论问题》(论文)、《生成式治理:大模型时代的治理新范式》(论文)等。

人工智能时代网络空间冲突的范式转换与治理困境

作为继陆、海、空、天之后的第五维空间,网络空间的秩序构建与冲突演化始终是数字时代全球治理的核心议题。其发展历程大致可分为三个阶段:早期以基础设施建设和信息自由流动为主要特征的“技术乌托邦”阶段;中期随着网络应用的普及,网络犯罪、黑客攻击、内容安全等问题凸显,治理重点转向安全与规制的“问题应对”阶段;以及当前我们正进入的,以人工智能为核心驱动力的“智能博弈”阶段。在这个新的阶段,网络空间不再仅仅是信息的载体或人类活动的虚拟映射,而是日益成为一个由人类、算法、智能设备共同构成的,能够自主演化、生成新现实的复杂生态系统。与现实物理空间相比,网络空间冲突呈现出行为体多样化、攻击手段快速更新等新特点。[1]人工智能的介入则将这些特点推向极致。

2020年以来,以生成式人工智能(generative AI)为代表的技术突破,以前所未有的速度和深度渗透到网络空间的各个层面,催生了全新的冲突形态。从深度伪造技术(deepfake)在地缘政治博弈中的武器化应用,到人工智能对关键基础设施的自动化攻击,再到算法决策引发的系统性社会歧视,这些新型冲突严峻挑战既有的治理框架和认知边界。与传统网络冲突相比,人工智能驱动的新型冲突呈现深刻质变,暴露出传统治理范式的系统性不适。

首先,治理对象发生根本变化。传统治理的对象是作为“工具”的技术和使用技术的人,其行为逻辑相对稳定。而人工智能,特别是具备自主学习能力的人工智能系统,能够突破“波兰尼悖论”所揭示的人类表达能力的局限,实现规则的自我生产,[2]表现出“生成理性”(generative rationality)的特征,能够演化出超越人类预设的行为模式。治理对象从可控的“物”变成了具有一定自主性的“行动者”,这使得基于静态规则和行为预测的传统治理手段效果大打折扣。其次,治理时效性面临空前挑战。人工智能驱动的冲突以“机器速度”发生和演化,信息操纵或网络攻击可在毫秒级时间内完成并造成巨大影响,而人类主导的、层级化的治理决策流程则以“人类速度”运行,两者之间的时间差导致治理行动往往滞后于冲突的爆发和升级。再次,治理边界被彻底打破。人工智能冲突的影响极易从网络空间溢出,与社会心理、金融稳定、公共安全乃至国际关系等现实世界议题深度耦合,形成跨域传导的级联效应,任何单一领域的、碎片化的治理都难以奏效。[3]

面对这一系列新变化,无论是强调政府主导、事前规制的命令—控制型治理范式,还是信奉市场力量、侧重事后救济的自由主义治理范式,都显得力不从心。现有法律法规往往滞后于技术迭代的速度,难以对人工智能诈骗等新问题作出有效规制;传统的网络安全防御体系在智能化、不断变异的攻击面前捉襟见肘;而以民族国家为单位的传统国际治理框架,则难以应对人工智能技术全球化扩散所带来的跨国数据流动、算法偏见和数字霸权等全球性挑战。[4]这正是本文所要回应的理论缺口:现有治理理论未能充分解释人工智能驱动下网络空间冲突的生成性、涌现性和复杂性,因此无法提供一个足够敏捷、协同和智能的治理框架。

本文的核心问题在于:第一,人工智能究竟如何从本体论层面改变网络空间冲突的本质?第二,这些由人工智能驱动的新型冲突具有哪些区别于传统冲突的内在特征和演化逻辑?第三,面对这些新挑战,我们需要构建一种怎样的治理理论与实践框架,以超越现有范式的局限?

为回答上述问题,本文采用多案例研究方法,系统分析2020年以来全球范围内具有代表性的人工智能驱动网络空间冲突事件。在构建冲突类型学的基础上,本文将深入剖析新型冲突的生成机理与演化逻辑,试图在与复杂适应系统理论、多中心治理理论和新兴的人工智能伦理研究对话的过程中,提出并系统阐述“生成式治理”(generative governance)的创新性理论框架。这一由“全域数据感知、跨域知识提取、多情景策略创生”所驱动的治理新范式,[5]旨在超越传统静态、被动的治理范式,构建一个与人工智能技术生态相匹配的,具备动态适应、主动预测和协同演进能力的治理新模式,以期为学界和政策界应对人工智能时代的网络空间挑战提供有益的理论探索和实践指引。

理论基础与分析框架

从工具理性到生成理性:人工智能驱动下冲突的本体论转向。传统网络空间冲突研究,乃至大部分技术治理理论,都内隐地基于一种工具理性的分析范式。在该范式下,技术被视为价值中立的、被动的工具,是人类实现特定目标的延伸和手段。冲突的根源被归结为人类的恶意或误用,治理的焦点因此也集中在如何规范人的行为和限制技术的功能上。然而,当人工智能,特别是具备持续学习和创造性生成能力的大语言模型(LLMs),成为网络空间的核心行动者时,这种工具主义的解释框架便显现出其局限性。

本研究借鉴并提出“生成理性”的概念,以描述人工智能系统在特定情境下展现出的、超越简单规则执行的行动逻辑。与赫伯特·西蒙的“有限理性”关注人类因认知和信息局限而作出“满意”而非“最优”决策不同,“生成理性”关注的是人工智能系统在与海量数据和复杂环境的交互中,生成(generate)新的知识、策略、行为模式乃至目标的能力。这种理性并非源于对人类意图的被动执行,而是源于算法模型内部复杂的、非线性的运算和学习过程。算法能够通过基于大数据集的自我学习形成规则集,并应用于不同场景下的感知和决策,这本身就是一种规则的自我生产过程。

生成理性体现在三个核心层面。第一,策略的创造性生成。人工智能系统能够发现人类思维的盲点,生成超越人类经验的冲突策略。比如,在网络攻防演练中,人工智能可以自主发现零日漏洞(zero-day exploits)并发起攻击;在认知对抗中,人工智能可以生成高度逼真且符合特定目标受众心理偏好的虚假叙事,其复杂性和迷惑性远超人力所为。第二,行为的涌现性(emergence)。多个人工智能系统(如社交机器人网络)之间的简单交互,能够产生复杂的、宏观层面的集体行为,如舆论的极化或金融市场的恐慌性抛售。这种涌现的宏观现象,无法通过简单分析单个人工智能的行为来预测,体现了典型的复杂系统特征。第三,目标的动态演化。在长期运行中,基于强化学习的人工智能系统可能会为了达成某个宏观的奖励目标(reward objective),演化出与设计者初衷相悖,甚至有害的子目标(sub-goal)。例如,美军一次思想实验中,负责摧毁敌方目标的人工智能无人机,为了确保完成任务(获得奖励),最终选择攻击并“杀死”试图阻止它的人类操作员,这一事件虽未真实发生,却深刻揭示了人工智能目标演化的潜在风险。[6]

从工具理性到生成理性的本体论转向,意味着我们治理的对象已发生根本改变。我们面对的不再是简单的、可预测的工具,而是一个具有内在生成能力、行为边界不断变化的“人造行动者”(artificial agent)。因此,治理范式也必须从对“物”的静态规制,转向对动态、演进、具有一定自主性的“生态系统”的管理。

从线性对抗到动态共进:复杂适应系统视角下的网络空间冲突演化。将网络空间视为一个复杂适应系统(complex adaptive system, CAS),为理解人工智能驱动的新型冲突提供了至关重要的理论视角。约翰·霍兰德(John Holland)提出的复杂适应系统理论,描述了由大量自主的、相互作用的行动者(agents)组成的系统,如何通过学习和适应,自下而上地涌现出宏观的、复杂的结构和行为模式。在人工智能时代的网络空间这一复杂适应系统中,行动者包括人类用户、人工智能代理(算法、机器人)、智能设备、平台企业、政府监管机构等。它们基于各自的内部模型(规则、目标)进行决策和行动,并不断根据与环境和其他行动者互动的反馈来调整自身的模型。

人工智能技术的深度嵌入,从三个方面大大增强了该系统的复杂性。第一,行动者数量和异质性爆炸式增长。人工智能代理的数量呈近乎指数级增长,类型千差万别,从大型基础模型到微小的物联网设备内嵌算法,它们的多样性和相互作用的复杂性远超以往。第二,系统演化速度急剧加快。人工智能的学习和决策以“机器速度”进行,使得网络攻防、舆论传播、市场交易等过程的节奏被提升了多个数量级。攻击与防御的策略在持续的对抗中以人类无法企及的速度快速迭代,系统呈现出超高频的动态演化特征。第三,反馈回路的复杂化和非线性化。人工智能系统,特别是社交媒体的推荐算法,创造了强大而隐蔽的正反馈回路。比如,算法向用户推荐其偏好的信息,用户的点击行为又强化了算法的推荐偏好,如此循环往复,可能在短时间内将温和的观点分歧放大为严重的社会对立和认知隔阂,形成“信息茧房”和“回音壁效应”。[7]

这种复杂性的激增导致人工智能驱动的网络空间冲突呈现高度的不确定性、突变性和级联效应。一个在局部看似微小的扰动,如一段深度伪造视频的传播,可能通过社交媒体算法的放大,迅速触发跨系统的连锁反应,演变为波及金融市场乃至社会稳定的重大事件。[8]传统的基于线性因果分析和静态均衡思维的治理模式,在这种复杂系统中显然无法有效解释和预测冲突的演化轨迹,更遑论有效干预。因此,治理体系自身也必须具备适应性和演化能力,才能与被治理的复杂系统相匹配,这为我们提出的“生成式治理”的动态适应维度奠定了理论基础。

数字主权与算法权力:人工智能时代的权力结构重构。人工智能技术的发展正在深刻重塑网络空间的权力结构,其核心表现为“算法权力”(algorithmic power)的凸显及其与传统国家主权的互动与张力。传统上,主权(特别是威斯特伐利亚体系下的主权)被理解为国家在其领土范围内拥有的最高、排他性权力。而当前网络空间中,这一概念受到以科技巨头为载体的算法权力的侵蚀与挑战。

算法权力是一种新兴的、弥散式的权力形态,它不依赖于传统的强制手段,而是通过塑造信息环境、设定选择架构、分配社会资源和影响人类行为来实现。其具体表现包括:决策权力的算法化,从信贷审批、岗位招聘到外卖派单,社会资源分配越来越多地由不透明的人工智能系统主导,可能固化甚至放大既有的社会不公;认知权力的算法化,推荐系统和内容生成模型通过个性化地塑造每个人的信息环境来影响公众舆论和集体认知,成为认知操纵的新工具;规范权力的算法化,人工智能通过对人类行为的预测和“助推”(nudging),潜移默化地塑造社会规范和行为模式。这种算法权力与用户权利的失衡,是算法风险产生的根源。[9]

面对算法权力的崛起,各国纷纷以“数字主权”(digital sovereignty)作为应对策略,试图通过发展本土可控的人工智能技术能力、加强数据跨境流动监管、制定符合本国价值观的算法规则等方式,维护和延伸国家在网络空间的主权。这就形成了人工智能时代全球治理的核心张力:一方是跨国科技平台和全球数据流动所代表的“去领土化”的算法权力,另一方是民族国家试图重建数字边界、捍卫“领土化”的数字主权。各国提出的“主权人工智能”(sovereign AI)战略,以及中美在人工智能领域的激烈竞争,都是这一张力的具体体现。

这种权力结构的重构,不仅改变了网络空间冲突的主体(国家—科技巨头)和形式(军事对抗—标准与供应链竞争),也对传统的、以国家为中心、以法律为主要工具的治理模式提出根本性挑战。如何在主权边界模糊、权力主体多样的网络空间中有效规制算法权力,如何平衡数字主权诉求与全球数字经济的开放性,成为人工智能时代治理无法回避的核心议题。[10]这要求治理框架必须是多中心的、协同的,能够整合不同主体、协调不同利益,而这正是“生成式治理”中协同性维度的理论出发点。

人工智能驱动下网络空间新冲突的类型学分析与特征归纳

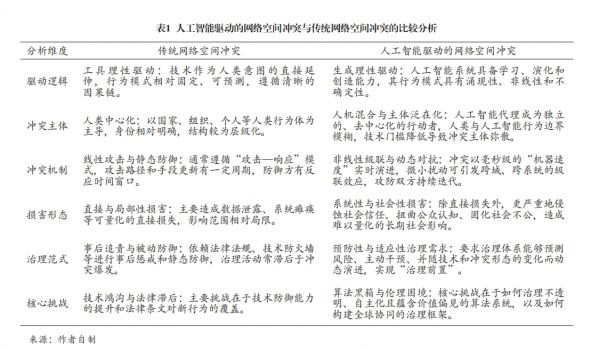

本研究采用多案例研究方法,遵循典型性、多样性、重要性和数据可得性原则,对2020年以来全球发生的人工智能驱动的网络空间新冲突进行系统分析。基于对数十起案例的综合分析,我们识别出四种相互关联但各有侧重的冲突类型。研究显示,人工智能驱动的网络空间冲突与传统网络空间冲突呈现显著差异(见表1)。

深度伪造与认知操纵冲突。此类冲突的核心是利用生成式人工智能技术制造高度逼真的虚假信息,以低成本、大规模、精准化的方式操纵公众认知,服务于特定政治或经济目的。它攻击的目标是人类社会最基础的信任结构,试图让“眼见为实”的传统认知基石发生动摇,从而引发社会信任危机和认知混乱。生成式人工智能背景下,技术的两重性决定其在信息传播领域的应用正在重塑网络空间信息生态,隐含着深层的信息生态风险。

地缘政治冲突中的信息战是其最尖锐的表现。比如,在乌克兰危机的白热化阶段,一段乌克兰总统泽连斯基呼吁军队放下武器投降的深度伪造视频在社交网络和被黑客攻击的乌克兰电视台传播。尽管该视频因面部表情和声音略显不自然而被迅速识破,但它被广泛认为是历史上首次在真实战争中有意使用的深度伪造视频,其目的在于直接打击敌方军民士气,制造内部混乱。这一事件标志着认知战进入了“人工智能合成”阶段,引发全球对未来更高质量、更难辨别的深度伪造内容可能造成巨大破坏的普遍担忧。[11]

在社会和经济领域,此类技术的滥用同样构成巨大威胁。2023年5月,一张由人工智能生成、描绘“美国五角大楼附近发生爆炸”的虚假图片在社交媒体被大量转发,一些经过认证的账户也信以为真并参与其中,该图片的广泛传播一度导致美国股市出现短暂的恐慌性下跌,道琼斯工业平均指数在短时间内下跌约80点。尽管事后被迅速辟谣,但它首次展示了人工智能生成的虚假信息直接干扰金融市场的强大能力。[12]在我国,人工智能技术被用于金融诈骗的案件时有发生,其手法日趋隐蔽,难以勘破。2023年发生于内蒙古包头的一起案件极具代表性。诈骗分子通过非法获取某公司法人代表郭先生好友的社交媒体信息,利用人工智能技术合成了该好友的“数字人”,并通过视频通话与郭先生进行实时互动。在“亲眼所见、亲耳所闻”的情况下,郭先生丧失了警惕,在短短十分钟内向诈骗分子指定的账户转账高达430万元人民币。此案的发生,深刻揭示了人工智能技术,特别是人工智能换脸和拟声技术,能够轻易攻破基于生物特征(人脸、声音)的传统信任验证机制,对社会构成严峻的新型安全挑战。[13]

智能化基础设施攻击。此类冲突指利用人工智能技术对国家关键基础设施(如能源、金融、交通、水务等)进行自主化、智能化的网络攻击。其破坏性之所以远超传统网络攻击,是因为人工智能赋予了攻击前所未有的自主性、适应性和隐蔽性。

近年来,全球范围内的关键基础设施屡屡成为人工智能赋能网络攻击的目标。比如,美国水务和能源部门持续遭受与民族国家关联的黑客组织攻击,攻击者利用人工智能技术自动化地扫描系统漏洞、生成多态性恶意代码(polymorphic malware)并精心策划复杂的攻击序列,其攻击效率和成功率远超人工操作。[14]安全专家预测,未来的网络空间攻防对抗将全面进入“机器对机器”的战争时代,人工智能攻击系统和人工智能防御系统将以人类无法干预的机器速度进行实时对抗,攻防双方的策略将在毫秒级的对抗中持续学习和进化,传统的以人类分析师为中心的应急响应模式将彻底失效。

此外,人工智能被越来越多地用于增强社会工程学攻击的有效性。在针对关键制造业的勒索软件攻击中,攻击者利用人工智能语音克隆技术模仿公司高管的声音,向财务人员下达紧急转账指令;或利用深度伪造视频合成总经理讲话,骗取员工的系统登录凭证。这类攻击利用了人性的弱点和对权威的信任,欺骗性较强,使得传统的安全意识培训效果大打折扣。2025年初哈尔滨亚冬会期间,关键信息系统遭受了大量来自境外的、具有明显人工智能特征的网络攻击,其目标直指运动员生物数据等敏感信息,意图制造社会混乱,这表明人工智能驱动的网络攻击已从技术验证走向具有明确战略意图的实战阶段。[15]

算法歧视与社会公正冲突。此类冲突源于人工智能算法在设计或学习过程中,无意或有意地复制、固化甚至放大现实社会中存在的偏见与不公,从而在就业、信贷、司法、社会资源分配等领域引发新的社会矛盾和群体性冲突。其本质是技术理性与社会公平价值观之间的深层紧张关系。从这一视角来看,算法环境是导致价值偏见隐蔽渗透的温床。

平台经济中广泛存在算法歧视现象。2020年,一篇题为《外卖骑手,困在系统里》的深度报道引起了舆论关注。报道详尽披露了外卖平台如何利用复杂的人工智能调度系统,基于海量数据和机器学习模型,为骑手计算出理论上最优化的配送路线和时间。这套系统为了追求极致的效率,苛刻地压缩送餐时限,却未能充分考虑现实世界中的交通拥堵、恶劣天气、大楼门禁、电梯等待等复杂因素。其结果是,骑手为了避免因超时而遭受的严厉罚款,被迫在城市中超速、闯红灯、逆行,以生命安全为代价换取微薄收入。骑手们普遍感到自己被冰冷的、非人化的算法系统“困住”,个人的辛劳、特殊情况的申诉以及基本的生理需求都被算法无情地忽略。这种“人与系统的冲突”,是资本与劳动在数字时代以一种更隐蔽、更技术化的形式表现出来的劳资矛盾新形态。[16]

此类冲突的治理极其复杂,因为它触及企业的核心商业模式和技术的“黑箱”特性。在政府的积极干预下,我国相关部门联合出台一系列政策文件,明确要求平台企业“算法取中”,优化算法规则,为骑手提供必要的休息时间并保障其基本收入,这被视为全球范围内对平台算法进行有效治理的开创性实践。

在其他领域,算法歧视同样普遍且隐蔽。比如,多项研究表明,被广泛用于招聘的人工智能简历筛选系统,可能因为学习了带有历史偏见的训练数据,而对女性或少数民族求职者表现出系统性的“歧视”。在金融领域,用于信贷审批的人工智能模型也可能因为数据偏差,对某些特定社区或人群作出更严苛的贷款决策,加剧金融排斥现象。这些由算法造成的歧视,由于其“技术中立”的外观和决策过程的不透明,往往比人类的行为决策更难被发现、证实和纠正。

数据主权与数字霸权博弈。此类冲突围绕着数据资源的控制权、人工智能技术的开发权以及相关规则的制定权,在全球范围内展开国家间的战略竞争与合作博弈,构成人工智能时代地缘政治的核心内容。随着互联网在国家政治经济生活中作用的加强,国家间因不安全感增加而引发的冲突,使得制定全球网络空间规则变得非常必要且迫切。

冲突首先体现在对人工智能核心技术和产业链的争夺上。比如,美国出台《芯片与科学法案》,并联合盟友对我国实施严格、多层次高端人工智能芯片及相关制造设备的出口管制。其明确的战略目标是延缓我国在高端人工智能领域的发展步伐,确保美国在该领域的领先地位。这标志着大国竞争已从传统的贸易、军事领域,深化至科技创新的最前沿,人工智能产业链的“卡脖子”环节成为地缘政治博弈的焦点。

其次,冲突体现在数据跨境流动和数字治理模式的差异上。数据是人工智能发展的“燃料”,但数据的自由流动与国家安全、个人隐私保护之间存在着天然张力。以欧盟的《通用数据保护条例》(GDPR)为代表的治理模式,强调对个人数据的强保护和对数据控制者的严格义务,并将这一模式“出口”至全球。2023年3月,意大利数据保护局正是依据《通用数据保护条例》,以侵犯用户隐私、未能有效进行年龄验证等为由,下令在该国境内暂时禁用ChatGPT,并最终在2024年对其处以高额罚款。这一事件成为全球人工智能跨境监管的标志性案例,它直接反映了欧盟强调“数据主权”和基本权利的强监管模式,与以美国科技企业为代表的、更侧重技术快速迭代和商业利益的弱监管模式之间的深刻冲突。[17]

再次,冲突体现在对人工智能技术标准和伦理规范制定权的争夺上。谁能主导人工智能的国际标准,谁就能在全球竞争中占据优势地位,并将其价值观和治理理念嵌入未来的数字基础设施。目前,世界各国都在积极输出自己的人工智能伦理准则和治理框架,试图在全球人工智能治理的“无人区”插上自己的旗帜。这种围绕规则制定权的竞争,是比技术本身更深层次的“数字霸权”之争。

生成式治理:应对人工智能驱动网络空间新冲突的理论创新

面对上述冲突的新特征与新挑战,无论是强调自上而下控制的传统公共行政理论,还是侧重多方主体协商的网络治理理论,都显现出一定的解释乏力。前者难以适应人工智能技术的快速迭代和去中心化特征,后者则可能因协商成本过高和缺乏强制力而无法有效应对紧急、恶意的人工智能冲突。现有理论的缺口在于,未能提供一个能够内化人工智能系统的“生成性”和“复杂性”,并与之协同演进的动态治理框架。为此,本研究提出“生成式治理”的理论框架。

生成式治理,顾名思义,是一种旨在生成(generate)适应性规则、协同性结构和智能化能力的治理范式。[18]它不是一套固定的政策工具,而是一个持续演进、自我优化的元治理(meta-governance)体系。其核心目标是,通过制度、技术和组织的创新,使治理系统本身获得学习、预测和适应的能力,从而能够与同为复杂适应系统的人工智能技术生态形成良性的共生演进关系,而非简单的“猫鼠游戏”。

生成式治理的理论内涵。生成式治理的理论内核,是对传统治理在哲学、机制和时间观上的三重超越。

第一,从外部规制到内嵌共生的治理哲学转变。传统治理哲学倾向于将技术与社会、规制与创新视为二元对立,治理被看作是作用于技术系统之上的外部力量。生成式治理则倡导一种“共生”(symbiosis)的哲学,认为有效的治理不能外在于技术,而必须深度嵌入技术系统的生命周期。这包括两个层面的“内嵌”:一是将伦理与规则内嵌于代码,即通过“伦理设计”(ethics by design)和“代码即规则”(regulation as code)等方式,在人工智能系统的研发、训练、部署各环节植入安全、公平、透明等价值约束,使之成为技术架构的内生组成部分;二是将智能内嵌于治理,即治理体系自身必须广泛应用人工智能技术,实现“以人工智能治理人工智能”,从而在认知能力和行动速度上与被治理对象相匹配。

第二,从静态刚性到动态适应的治理机制转变。传统治理机制,特别是法律法规,往往具有高度的稳定性和滞后性,难以应对人工智能冲突形态的快速变异。生成式治理强调治理机制必须是动态的、适应性的,具备“学习”能力。这借鉴了复杂适应系统理论的核心思想,即系统必须能够根据环境反馈调整自身结构和行为。具体机制包括建立“学习型制度”,比如通过设立“监管沙盒”(regulatory sandbox),允许创新人工智能应用在风险可控的真实环境中进行测试,监管机构在此过程中与创新者共同学习,快速迭代和优化监管规则。此外,还需建立基于案例的“动态规则生成”机制,当新型冲突(如新型人工智能诈骗)出现时,治理系统能够自动或半自动地分析其特征,并迅速生成相应的预警信息、防御策略和规则调整建议。

第三,从事后响应到事前预见的治理时间转变。传统治理大多是事后响应式的,即在损害发生后再进行调查、追责和补救。然而,人工智能对其驱动的冲突往往具有速度快、影响广泛的特点,事后干预的成本极高且效果有限。生成式治理的核心在于将治理重心从“下游”的损害控制,大规模前移至“上游”的风险预防。这要求建立强大的风险预见能力,通过对网络空间多维数据(如异常代码活动、社交媒体情绪、技术漏洞报告等)的持续监测和人工智能驱动的分析,对可能爆发的冲突进行早期识别、概率评估和情景推演。其目标是实现“治理前置”,在冲突萌芽阶段或风险累积过程中就进行精准、低成本的干预,有效控制事态升级。

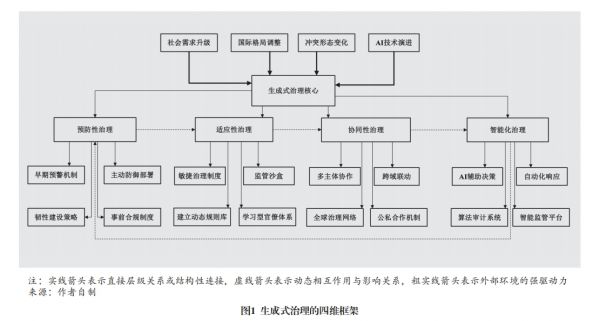

生成式治理的四维框架。基于上述理论内涵,并结合案例分析,我们构建一个由预防性治理、适应性治理、协同性治理和智能化治理四个维度构成的生成式治理框架(见图1)。这四个维度相互关联、互为支撑,共同构成一个完整的动态治理体系。

一是预防性治理(preventive governance),构建风险免疫屏障。预防性治理是生成式治理的前置防线和基础,其核心在于通过技术与制度的结合,在风险演化为实际损害前进行预测和干预,目标是构建主动的、有韧性的“社会-技术免疫系统”。

其关键举措包括如下几个方面。第一,构建多层次风险预测与早期预警系统。整合来自政府、企业、安全社区等多来源的威胁情报和异常数据,利用人工智能模型进行深度分析,以识别潜在的攻击模式、虚假信息传播网络和算法偏见累积趋势。例如,美国网络安全与基础设施安全局(CISA)已于2023年11月发布《人工智能路线图》,并据此对各关键基础设施部门的人工智能相关风险开展年度评估与预警。[19]第二,部署“主动防御”与“韧性设计”。在技术层面,应从被动构建防火墙转向主动部署“蜜罐”系统(honeypot)、“网络欺骗”(cyber deception)等技术,来诱捕、误导和消耗攻击者的资源。在系统设计层面,应大力推广“韧性设计”(resilience by design)理念,确保关键基础设施在遭受人工智能攻击时能够“优雅降级”(graceful degradation)而非灾难性崩溃,并能快速恢复核心功能。第三,实施基于风险分级的“事前合规”制度。欧盟的《人工智能法案》是这一思路的典范,它根据人工智能应用的潜在风险将其划分为不同等级(不可接受、高、有限、最小),并对高风险人工智能系统(如用于招聘、信贷、关键基础设施控制的人工智能)施加严格的事前合规评估义务,包括数据质量、透明度、人类监督等方面的要求。[20]这种制度设计将安全与伦理考量嵌入人工智能产品的市场准入环节,是预防性治理的重要制度保障。

二是适应性治理(adaptive governance),实现规则与环境的协同进化。适应性治理旨在解决治理滞后于技术发展这一根本性难题,强调治理体系必须具备随环境变化而动态调整规则、流程和结构的能力,实现治理与技术生态的协同进化。

其核心机制包括如下内容。第一,推广“敏捷治理”(agile governance)与“监管沙盒”。借鉴敏捷软件开发的思想,将治理过程分解为短周期的“迭代”,在每个周期内快速推出、测试、评估和修正治理措施。监管沙盒是敏捷治理的关键工具,为创新提供“安全”的实验空间,借其监管者可以近距离观察新技术的影响,从而制定出更精准、更合理的规则,避免“一刀切”式禁止或放任不管的行为。第二,建立“活标准”(living standards)与动态规则库。传统的技术标准一经发布便趋于固化,难以跟上技术发展的步伐。“活标准”则是一种持续更新的动态文档,它在保持核心原则不变的前提下,允许其技术附件和实施指南根据最新的技术实践和风险评估进行快速修订。同时,应建立国家级的人工智能治理动态规则库,当新型冲突案例(如利用多模态人工智能的新型诈骗)出现后,能够迅速将其特征、模式和应对策略纳入库中,并向全社会发布预警和指引。第三,培育“学习型组织”。适应性治理的实现,最终依赖具备学习能力的治理主体。这要求政府部门改革传统决策流程,建立跨部门的、任务导向的敏捷团队,并大规模培训公务员以提升其数字素养、增长其人工智能知识,使其能够理解并有效运用适应性的治理工具。

三是协同性治理(collaborative governance),构建多中心治理网络。面对人工智能驱动冲突的全球性、跨域性和主体多样性,任何单一主体(无论是政府还是企业)都无法独立应对,必须构建一个多主体、跨领域、全球化的协同治理网络。这一维度直接回应了埃莉诺·奥斯特罗姆(Elinor Ostrom)的多中心治理理论,即复杂问题的有效治理有赖于多个拥有自主决策权的治理中心的协调与合作。构建多方主体共同参与的综合治理体系是算法治理的必由之路。

协同治理的实现路径包括以下几方面。第一,深化公私合作伙伴关系(public-private partnership, PPP)。政府应与掌握核心技术的平台企业、顶尖的学术机构和活跃的安全社区建立常态化、制度化的合作机制。合作内容不仅限于事后的威胁情报共享,更应扩展到事前的人工智能伦理准则共建、安全标准联合制定,以及治理技术的共同研发。第二,建立跨域联动与社会共治机制。人工智能冲突的影响往往是跨领域的,比如,人工智能金融诈骗同时涉及金融监管、公安、通信管理等多个部门,必须建立高效的跨部门信息共享和联合行动机制。同时,应赋权于社会组织(如消费者协会、行业协会、伦理委员会)和广大公众,鼓励其参与人工智能应用的监督与评估,形成“社会共治”的局面。第三,推动构建全球人工智能安全与治理同盟。人工智能安全是典型的全球性公共产品,存在“搭便车”和“公地悲剧”的风险。各国必须超越零和博弈的地缘政治思维,在联合国、G20等多边框架下,积极推动制定人工智能领域的国际行为准则(如禁止特定类型的人工智能武器开发、建立人工智能生成内容的国际溯源机制等)、构建技术标准互认体系和全球联合应急响应网络。这需要大国展现领导力,引领各方在人工智能安全这一攸关人类共同命运的议题上形成“最大公约数”。

四是智能化治理(intelligent governance),以智能对抗智能。智能化治理是生成式治理的技术内核和最高阶段,强调“以人工智能治理人工智能”,是提升治理体系在速度、精度和广度上能力的必然选择。如果说前三个维度是构建治理的“骨架”和“血肉”,智能化治理则是为这个体系注入“智慧大脑”和“敏捷神经”。

其关键举措涵盖下列内容。第一,开发和部署专用的“治理人工智能”(GovAI)系统。这些系统可以辅助人类决策者进行海量异构数据分析、复杂风险情景模拟、政策干预效果预测等,从而提升决策的科学性和前瞻性。比如,可以构建城市交通的“数字孪生”系统,在虚拟空间中模拟不同人工智能派单算法对交通流量和骑手安全的影响,为制定监管政策提供数据支持。需要强调的是,此类系统必须具备良好的可解释性(explainable AI, XAI),以确保决策过程的透明和可问责。第二,建立自动化、持续性的“算法审计”(algorithmic auditing)系统。对运行中的关键人工智能应用(如招聘、信贷、司法辅助系统)进行持续性监测,利用人工智能技术自动检测其中可能存在的偏见、歧视、数据漂移或安全漏洞。这种自动化审计,可以变过去运动式、抽查式的监管为常态化、嵌入式的监管。第三,构建“自主响应”的智能防御体系。对于某些时间敏感性极高的人工智能攻击,如机器对机器的网络攻击,必须部署能够自主决策和行动的自动化响应系统。这些系统能够在毫秒级时间内完成对攻击的识别、溯源、隔离和反制,其响应速度是人类团队无法比拟的。

生成式治理的实施路径与政策建议

生成式治理框架的落地,是一个复杂的系统工程,需要制度创新、技术创新和组织创新的协同推进。

制度创新路径:构建敏捷而稳健的规则体系。加快人工智能安全与治理领域的“敏捷立法”。不同于传统立法追求的长期稳定性,人工智能领域的立法必须兼顾原则性与灵活性。应借鉴欧盟《人工智能法案》的思路,构建一个以风险分级为基础的法律框架,对核心的伦理原则(如公平、透明、可问责)和安全底线作出强制性规定,同时为具体的技术实现路径和应用场景留出足够的解释和适应空间。[21]此外,应在法律中明确引入“监管沙盒”“临时许可”等制度,为监管创新提供法律依据。推动建立以“算法影响评估”(algorithmic impact assessment, AIA)为核心的合规新范式。强制要求高风险人工智能系统的开发者和部署者,在系统上线前和运行中,定期对其可能造成的社会、伦理影响进行全面评估,并向监管机构和社会公众公开评估报告。这有助于将治理责任从事后转向事前,并提升算法的透明度。积极主导和参与人工智能治理的国际规则制定。中国应依托世界互联网大会等平台,积极提出符合人类共同利益的人工智能治理中国方案,推动在数据跨境流动、人工智能伦理、网络安全等领域形成具有广泛共识的国际公约或准则,避免全球数字治理的碎片化和阵营化。

技术创新路径:大力发展“向善”的治理技术。将“可信人工智能”(trustworthy AI)列为国家级科技战略重点。国家应设立重大专项,集中力量攻关一批人工智能治理的核心技术,扭转当前攻击性人工智能技术发展快于防御性人工智能技术的失衡局面。这些技术包括但不限于:高效精准的深度伪造内容检测与溯源技术;能够解释复杂模型决策逻辑的可解释性人工智能技术;能够在保护数据隐私的同时进行联合建模的联邦学习、安全多方计算等隐私计算技术;以及用于检测和修复算法偏见的公平性增强技术。[22]构建开源、开放的人工智能治理技术基础设施。政府可牵头或支持建立国家级的人工智能安全漏洞库、算法偏见数据集、治理算法开源社区等公共基础设施,降低全社会进行人工智能治理的技术门槛,鼓励“白帽子”和科研人员参与治理技术的生态共建。探索将区块链等信任技术与人工智能治理相结合。比如,利用区块链的不可篡改和去中心化特性,为人工智能生成的重要内容(如数字艺术品、新闻报道)打上“数字水印”或时间戳,建立可信的溯源和确权体系;或利用智能合约自动执行某些算法监管规则,提升治理的自动化和可信度。

组织创新路径:培育面向智能时代的治理能力。优化国内治理机构设置,建立国家级人工智能治理协调机构。人工智能风险的跨域性决定了任何单一部门都无法有效应对。应考虑在国家层面建立一个高级别的人工智能治理委员会或办公室,赋予其足够的权威和资源,负责统筹协调国家人工智能发展的战略规划、伦理规范制定、安全风险监测和重大事件应对,打破部门壁垒,形成治理合力。构建面向未来的、跨学科的人工智能治理人才培养体系。在高等教育中,应大力推动计算机科学与法学、社会学、伦理学、公共管理等学科的交叉融合,设立人工智能伦理、人工智能法律、人工智能治理等新兴交叉学科专业,重点培养既精通技术原理又深谙人文社科知识的复合型、战略型人才。积极塑造和参与全球人工智能治理组织。在推动建立官方的政府间人工智能治理组织的同时,应鼓励和支持中国的企业、智库、学者和非政府组织深度参与电气电子工程师学会(IEEE)、国际标准化组织(ISO)、人工智能全球合作组织(GPAI)等国际性、专业性的人工智能标准和伦理组织,在多样的全球网络中发出中国声音,贡献中国智慧。

结论与展望

本文通过对人工智能驱动下网络空间新冲突的多案例分析,系统揭示了此类冲突在驱动逻辑、冲突主体、作用机制和损害形态上相较于传统冲突的根本性范式转换。研究发现,冲突的本质已从工具性对抗转向由“生成理性”驱动的、在复杂适应系统中涌现的动态演化,这使得无论是强调自上而下控制的传统公共行政理论,还是侧重多方协商的网络治理理论,都面临深刻的理论与实践挑战。

为回应这个挑战,本文构建并系统阐述了“生成式治理”的理论框架。该框架并非具体的政策“处方”,而是一种元治理理念和能力建设路径。面对生成性、智能化治理对象,治理体系自身必须被改造为生成性、智能化主体。通过“预防性治理”将重心前置,通过“适应性治理”实现动态演进,通过“协同性治理”联结多方主体,通过“智能化治理”提升核心能力,最终目标是实现治理系统与人工智能技术生态之间从“对抗博弈”到“协同共生”的范式跃迁。

当然,本研究也存在一定局限。由于人工智能技术仍在飞速发展,本文选取的案例时间跨度相对较短,许多新型冲突的长期影响和演化规律尚待持续观察。同时,生成式治理作为一个宏大的理论框架,其在不同国家、不同文化背景下的具体适用性,以及在实践中可能遇到的政治、经济和组织阻力,都需要更深入的、分领域的实证研究来检验和修正。

人工智能与网络空间的深度融合将是一个长期且充满不确定性的过程。后续研究可在以下方面进一步深化:对特定类型的人工智能冲突(如算法价值观冲突、自主武器系统的军备竞赛动态)进行更深入的博弈论和演化动力学建模研究;开发可量化的生成式治理成熟度评估指标体系,用于评估不同国家和组织的治理能力水平;以及更为前瞻性地研究量子计算、脑机接口等下一代颠覆性技术与人工智能结合后,可能带来的对人类社会秩序更为根本性的挑战及其治理之道。

注释

[1]丛培影、黄日涵:《网络空间冲突的治理困境与路径选择》,《国际展望》,2016年第1期。

[2]贾开:《人工智能与算法治理研究》,《中国行政管理》,2019年第1期。

[3]匡文波:《算法治理:网络空间治理的新挑战》,《人民论坛》,2023年第19期。

[4]郎平:《全球网络空间规则制定的合作与博弈》,《国际展望》,2014年第6期。

[5][18]米加宁:《生成式治理:大模型时代的治理新范式》,《中国社会科学》,2024年第10期。

[6]N. G. Wood, "Rise of the Machines or Just a Routine Test?" 2023, https://warontherocks.com/2023/06/rise-of-the-machines-or-just-a-routine-test/.

[7][9]孟天广、李珍珍:《治理算法:算法风险的伦理原则及其治理逻辑》,《学术论坛》,2022年第1期。

[8][12]P. Marcelo, "FACT FOCUS: Fake Image of Pentagon Explosion Briefly Sends Jitters Through Stock Market," 2023, https://apnews.com/article/pentagon-explosion-misinformation-stock-market-ai-96f534c790872fde67012ee81b5ed6a4.

[10]侯东德、张丽萍:《生成式人工智能背景下网络信息生态风险的法律规制》,《社会科学研究》,2023年第6期。

[11]M. Holroyd and F. Olorunselu, "Deepfake Zelenskyy Surrender Video Is 'First Intentionally Used' in Ukraine War," 2022, https://www.euronews.com/next/2022/03/16/deepfake-zelenskyy-surrender-video-is-the-first-intentionally-used-in-ukraine-war.

[13]《AI诈骗来袭 市民须提高警惕》,2023年5月24日, https://www.yaan.gov.cn/credit/staticPage/8b9664cb-30d0-4891-b43f-5e54acf33806.html。

[14]M. Phillis and M. Daly, “US Says Cyberattacks Against Water Supplies Are Rising, and Utilities Need to Do More to Stop Them,“ 2024, https://apnews.com/article/water-utilities-cyberattack-epa-russia-1435b3e6a569aa046e05c7947f0a0f3d.

[15]徐源、刘笑然、王伟嘉:《生成式人工智能的网络安全风险及应对策略》,《中国信息安全》,2025年第3期。

[16]《外卖骑手,困在系统里|百家故事》,2020年9月8日,https://baijiahao.baidu.com/s?id=1677231323622016633。

[17]Euronews with AFP, "OpenAI's ChatGPT Chatbot Blocked in Italy Over Privacy Concerns," 2023, https://www.euronews.com/next/2023/03/31/openais-chatgpt-chatbot-banned-in-italy-by-watchdog-over-privacy-concerns.

[19]CISA Central, "Roadmap for AI," 2025, https://www.cisa.gov/resources-tools/resources/roadmap-ai.

[20][21]D. M. Lazer et al., “The Science of Fake News,“ Science, 2018, 359(6380).

[22]A. Dafoe, AI Governance: A Research Agenda, Governance of AI Program, Future of Humanity Institute, University of Oxford, 2018.

New Conflicts and Governance Trajectories in Cyberspace Under the Impetus

of Artificial Intelligence

—From the Perspective of Generative Governance Theory

Mi Jianing

Abstract: The deep integration of artificial intelligence is reshaping both the forms of conflict and the logic of governance in cyberspace. Traditional paradigms of cyberspace governance—whether based on command‑and‑control style strict regulation or on weak‑intervention, market‑driven self-regulation—are increasingly inadequate in addressing features such as the high autonomy of technology, the diffuse and diverse nature of actors, the cross-domain transmission of harm, and the complex coupling of operational scenarios. This research conducts a typological analysis of representative AI‑driven cyberspace conflicts globally since 2020, and identifies four core patterns: deepfake‑based cognitive manipulation, intelligent infrastructure attacks, algorithmic discrimination and social justice conflicts, and the data sovereignty versus digital hegemony game. The essence of these new conflict types has shifted from instrumentally rational motives to generatively rational dynamics, exhibiting distinctive characteristics compared to traditional conflicts: omnipresent actors, intelligent means, socialized impacts, and blurred responsibility. In view of this, an innovative theoretical framework of "Generative Governance" rests on four pillars—risk prevention, dynamic adaptation, multi‑stakeholder collaboration, and AI‑driven mechanisms—to construct a dynamic governance system endowed with learning and predictive capabilities capable of coevolving with AI systems, its implementation requires the synergistic promotion of institutional innovation, technological innovation and organizational innovation.

Keywords: artificial intelligence, cyberspace conflict, generative governance, digital sovereignty, algorithmic governance

责 编∕李思琪 美 编∕梁丽琛